Projektbericht: Automatische Aggregation wissenschaftlicher Volltexte für die Anreicherung von OA-Repositorien

von Najko Jahn & Mathias Lösch

Wie lassen sich im Web befindliche Publikationen wissenschaftlicher Angehöriger einer Universität mit möglichst einfachen Mitteln finden? Was verraten sie über wissenschaftliche Kommunikation allgemein? Und wie lassen sie sich im Besonderen für bibliothekarische Dienste wie Institutionelle Repositorien nachnutzen?

Diese Frage stellten wir uns vor dem Hintergrund zweier von der DFG geförderten Projekte an der Universitätsbibliothek Bielefeld, „Persönliche Publikationslisten als hochschulweiter Dienst (PubLister)“ und „Automatische Anreicherung von OAI-Metadaten mit Hilfe computerlinguistischer Verfahren und Entwicklung von Services für die inhaltsorientierte Vernetzung von Repositorien“. Insgesamt konnten wir aus 750 im Web veröffentlichten persönlichen Publikationslisten der Universität Bielefeld über die Suchmaschine Bing 3380 Volltext-Links aggregieren, die für bibliothekarische Dienste eine wertvolle Datenbasis bilden können.

Persönliche Publikationslisten als Quelle der Dokumentenakquise für OA-Repositorien?

Persönliche Publikationslisten im Web gelten schon lange als wichtiges Informationsmittel in den Wissenschaften. Forschende weisen damit nicht nur ihre Publikationen nach, sondern sie nutzen ihre Webseiten auch für die Erstveröffentlichung von Forschungsbeiträgen.

Universitäten haben allerdings nur selten einen Überblick über den so dokumentierten wissenschaftlichen Output, was vor allem an fehlenden Methoden für die Einbettung des persönlichen Webauftrittes in eine gesamtuniversitäre Nachweislandschaft liegt.[1]

Bibliotheken sehen im Umfeld des Publikationsmanagements diese Chancen bereits und stellen zentrale, web-basierten Plattformen bereit, wie z.B, institutionelle Open Access-Repositorien, Forschungsinformationssysteme oder Jahresbibliographien. Diese Systeme ermöglichen die automatische Generierung und Veröffentlichung persönlicher Publikationslisten als Webseiten.

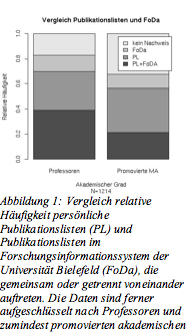

Aber nicht alle Universitäten bieten solche Plattformen an und selbst wenn sie vorhanden sind, steht ihre Nutzung als Nachweisinstrument in keinem Verhältnis zu den unstrukturierten Veröffentlichungen in Form manuell gestalteter Listen, wie das Beispiel Universität Bielefeld zeigt.

Die Webometrie hat diese Diskrepanz zwischen dem Abdeckungsgrad bibliometrischer Quellen jeglicher Art und den individuellen Publikationsstrategien im Web seit langem erkannt und wählt einen komplementären Ansatz zu klassischen bibliometrischen Datenerhebungsmethoden. Anstatt bibliographische Datenbanken für die Sammlung wissenschaftlicher Veröffentlichungen heranzuziehen, greift sie auf Web-Suchmaschinen wie Google, Yahoo! oder Bing zurück, um wissenschaftliche Strukturbildungsprozesse für die Analyse zugänglich zu machen. Ihre Prämisse ist dabei bestechend:

„Webometrics, the quantitative study of Web-related phenomena, emerged from the realization that methods originally designed for bibliometric analysis of scientific journal article citation patterns could be applied to the Web, with commercial search engines providing the raw data.“[2]

Ermutigt von dem offensichtlichen Datenreichtum persönlicher Publikationslisten wollten wir wissen, inwieweit kommerzielle Web-Suchmaschinen geeignet sind, um in relativ kurzer Zeit und mit vergleichsweise geringem Aufwand einen kritischen Bestand an wissenschaftlichen Veröffentlichungen zu aggregieren.

Methode

Aus den Homepages der wissenschaftlichen Angehörigen der Universität Bielefeld extrahierten wir sämtliche Links, die auf Dokumente mit der Dateiendung „.pdf „bzw. „.doc“ zeigten. Wir nutzten dazu Entwicklungen aus dem DFG-Projekt „Automatische Anreicherung von OAI-Metadaten“. Um die Links mit zusätzlichen Informationen aus dem Dokument selbst anzureichern, sendeten wir die URLs als Anfrage an Bing und nutzten den bestgerankten Eintrag in der resultierenden Trefferliste als „bibliographische Beschreibung“. Die Prämisse ist dabei, dass das Dokument hinter der URL von Bing indexiert wurde und der erste Eintrag in den Suchergebnissen einen inhaltlich relevanten Auszug aus dem Text enthält.

Die Volltextlinks werden dann gemeinsam mit Autorenname und einer kurzen Titelbeschreibung in einer Liste präsentiert.

Erste Ergebnisse

Nachfolgend beschreiben wir erste Ergebnisse, die uns ermutigen, unseren Ansatz weiterzuverfolgen und auszubauen. Sie sollen im Kurzen erläutert und im weiteren Projektverlauf einer eingehenden Überprüfung und Diskussion zugeführt werden.

1. Schritt – Aggregation von Volltextlinks

Insgesamt haben wir 3380 PDF-Links und 15 MS-Word-Links extrahiert. Stichprobenartig konnten wir feststellen, dass tatsächlich ein Großteil der Links gefunden wurde. Die Extraktion wird allerdings negativ beeinflusst von scriptgenerierten Publikationslisten, wie sie etwa von CiteLine angeboten werden: auf solchen Seiten versagt zum einen der Link-Extraktionsalgorithmus häufig, zum anderen wurden die auf solchen Seiten gelisteten Volltexte oft nicht von der Suchmaschine indexiert, was dazu führt, dass der Link nicht mit Zusatzinformationen angereichert wird.

2. Schritt – Dokumentenumfang

Wir können derzeit noch nicht automatisch unterscheiden, ob der Link tatsächlich auf ein im Uni-CMS verfügbares Dokument oder auf ein Verlagsangebot verweist. Ein weiteres Problem stellen irrelevante Dokumente wie z.B. Lebensläufe dar, die ebenfalls auf den persönlichen Seiten veröffentlicht werden. Jedoch zeigt sich auch hier die Tendenz, dass die Dokumente überwiegend verfügbar und zum Großteil wissenschaftliche Publikationen sind.

Ein weiteres Problem sind Mehrfachaffiliationen von Autoren, die die Gesamtsumme verfälschen. Dies konnte jedoch durch eine einfache Doublettenkontrolle korrigiert werden.

3. Schritt – Anreicherung durch Suchmaschinen

Wir haben uns für Bing entschieden, weil in Vorabversuchen mit dieser Suchmaschine die beste Indexierungsqualität erreicht wurde. Die besten Resultate erreichen annähernd die Qualität von bibliographischen Angaben. Allerdings finden sich auch viele unzureichende Einträge in unserer Liste. Diese sind z.B. dadurch charakterisiert, dass entweder gar keine Zusatzinformationen gefunden wurden, was daran liegt, dass das Dokument nicht indexiert wurde. In anderen Fällen werden nutzlose, weil bereits bekannte Daten (z.B. die URL oder der Autorenname) bzw. „Datenmüll“ (z.B. Sonderzeichen) zurückgeliefert. Letzteres liegt vermutlich daran, dass die interne Struktur des Volltextdokuments eine qualitativ hochwertige Indexierung durch die Suchmaschine verhindert hat.

4. Schritt – statistische Auswertung

In ersten statistischen Analysen zeigen sich altbekannte Muster wissenschaftlichen Publikationsverhaltens: Wir finden Listen mit besonders vielen Publikationen insbesondere in den Natur- und Ingenieurswissenschaften, was plausibel erscheint, da in diesen Disziplinen Zeitschriftenartikel und Konferenzbeiträge die dominierende Form der wissenschaftlichen Kommunikation sind. Eher schwächer zeigen sich die Geistes- und Sozialwissenschaften, deren traditionell wichtigste Publikationsform die Monographie ist.

Auch wenn diese Vorabbefunde plausibel erscheinen, steht jedoch eine genauere statistische Auswertung auf Listen- und Dokumentebene, die sie stützen könnte, noch aus.

Diskussion

Berücksichtigt man die Einfachheit unseres Ansatzes und die Kürze der Zeit, die er in Anspruch nahm, so erscheinen die ersten Ergebnisse durchaus vielversprechend und sie ermutigen uns, die Methode weiter auszubauen. Webometrische Ansätze scheinen tatsächlich eine wertvolle Ergänzung für die Sammlung wissenschaftlicher Dokumente darzustellen. Mit Methoden des Information Extraction angewandt auf die PDFs hoffen wir, den Inhalt zukünftig noch genauer bestimmen zu können. Unser Programm könnte zudem mit wenig Aufwand so konfiguriert werden, dass es die Publikationslisten in regelmäßigen Abständen abarbeitet und neu gefundene Links gesondert auszeichnet bzw. strukturiert zugänglich macht. Dadurch könnte ein einfaches hochschulweites Monitoring der Publikationsaktivität erreicht werden. Außerdem bedarf es einer weitergehenden statistischen Auswertung, um belastbare Aussagen über das Publikationsverhalten von Wissenschaftlern auf ihren Webseiten aufstellen zu können. Hierbei könnte z.B. die Länge der gefundenen Volltexte berücksichtigt werden, um ein differenzierteres Bild des Publikationsverhaltens einzelner Einrichtungen zu zeichnen.

Welche Qualität und welchen Umfang das harvesting persönlicher Webseiten von Wissenschaftlern erreichen kann, zeigt das disziplinspezifische Netzwerk PhilPapers.org, das bis dato mehr als 200.000 philosophischer Dokumente gesammelt, erschlossen und viele von ihnen frei zur Verfügung gestellt hat. Neben bibliographischen Datenbanken und von den Autoren selbst eingestellten Publikationen ist dort die automatische Aggregation von Volltexten durch Parsing von persönlichen Publikationslisten die wichtigste Datenquelle.

Insgesamt zeigt unser Ansatz, dass sich durch automatische Extraktion von Volltextlinks und deren automatische Kontextualisierung mit Hilfe kommerzieller Suchmaschinen in kurzer Zeit eine aussagekräftige Liste der im Web verfügbaren Publikationen der Hochschuleinrichtungen generieren lässt. Würden diese Informationen als Anreiz in die Publikationsdienste einer Universität eingebunden, womöglich noch verbunden mit dem Angebot an den Autor, seine gefundenen Publikationen semi-automatisch in ein Repositorium zu integrieren, könnte das den Bestandsaufbau elektronischer Dokumente deutlich beschleunigen. Der Upload der eigenen Publikationen wäre für den Wissenschaftler dann buchstäblich nur noch „einen Klick entfernt.“

[1] Aguillo, I. (2009). Measuring the institution’s footprint on the web. Library Hi Tech, 27(4), pp. 540-556.

[2] Thelwall, M., Vaughan, L., Björneborn, L. (2005) Webometrics : Information retrieval. Annual review of information science and technology. 2005, vol. 39, p.81.

[…] Projektbericht: Automatische Aggregation wissenschaftlicher Volltexte für die Anreicherung von … Projektbericht: Automatische Aggregation wissenschaftl. Volltexte für d Anreicherung von OA-Repositorien http://bit.ly/abbnst (tags: twitter_automatisch) […]

Weitere methodische Überlegungen und Ergebnisse der kleinen Studie wurden hier publiziert:

Jahn, Najko; Lösch, Mathias; Horstmann, Wolfram (2011): Persönliche Publikationslisten im WWW – Webometrische Aspekte wissenschaftlicher Selbstdarstellung am Beispiel der Universität Bielefeld. In: Schomburg, Silke; Leggewie, Claus; Lobin, Henning; Puschmann, Cornelius (Hrsg.): Digitale Wissenschaft: Stand und Entwicklung digital vernetzter Forschung in Deutschland, Köln: hbz, S. 227 – 232. http://pub.uni-bielefeld.de/publication/2295509

Jahn, Najko; Lösch, Mathias; Horstmann, Wolfram (2010): Automatic Aggregation of Faculty Publications from Personal Web Pages. In: code4lib (11). http://journal.code4lib.org/articles/3765